Обработка логов с помощью OpenPipeline

Ключ-АСТРОМ версии 1.295+

OpenPipeline — это решение Ключ-АСТРОМ для обработки данных логов из различных источников. Оно обеспечивает лёгкую обработку данных любого масштаба и формата на платформе Ключ-АСТРОМ. Использование OpenPipeline при обработке логов в Ключ-АСТРОМ — это мощное решение для управления, обработки и анализа логов. Этот подход сочетает традиционные возможности обработки логов с расширенными функциями OpenPipeline для обработки данных, обеспечивая более глубокое понимание данных логов.

Для кого это?

Эта статья предназначена для администраторов и пользователей приложения.

Чему вы научитесь

В этой статье вы научитесь обрабатывать логи для улучшения наблюдаемости, включая фильтрацию, обогащение и маршрутизацию.

Прежде чем начать

Преимущества

OpenPipeline обеспечивает следующие преимущества:

- Контекстное преобразование данных: OpenPipeline извлекает данные вместе с контекстом и преобразует их в более эффективные форматы, например, преобразует логи в бизнес-события.

- Унифицированный язык обработки: в качестве языка обработки используется DQL, предлагающий единый синтаксис для всех функций Ключ-АСТРОМ и более расширенные возможности обработки.

- Концепции конвейеров: Трафик приема логов можно разделить на разные конвейеры с выделенной обработкой, извлечением данных и метрик, разрешениями и хранением.

- Дополнительные процессоры: вы можете использовать дополнительные процессоры, такие как

fieldsAdd,fieldsRemove, и другие. Полный список см. в разделе Обработка OpenPipeline. - Расширенные возможности извлечения данных: извлекайте бизнес-события из логов с помощью дополнительных возможностей извлечения данных.

- Расширенные лимиты: воспользуйтесь расширенными лимитами по умолчанию, включая размер контента до 524 288 байт, размер атрибутов до 2500 байт и до 250 атрибутов логов.

- Улучшенная производительность и более высокая пропускная способность.

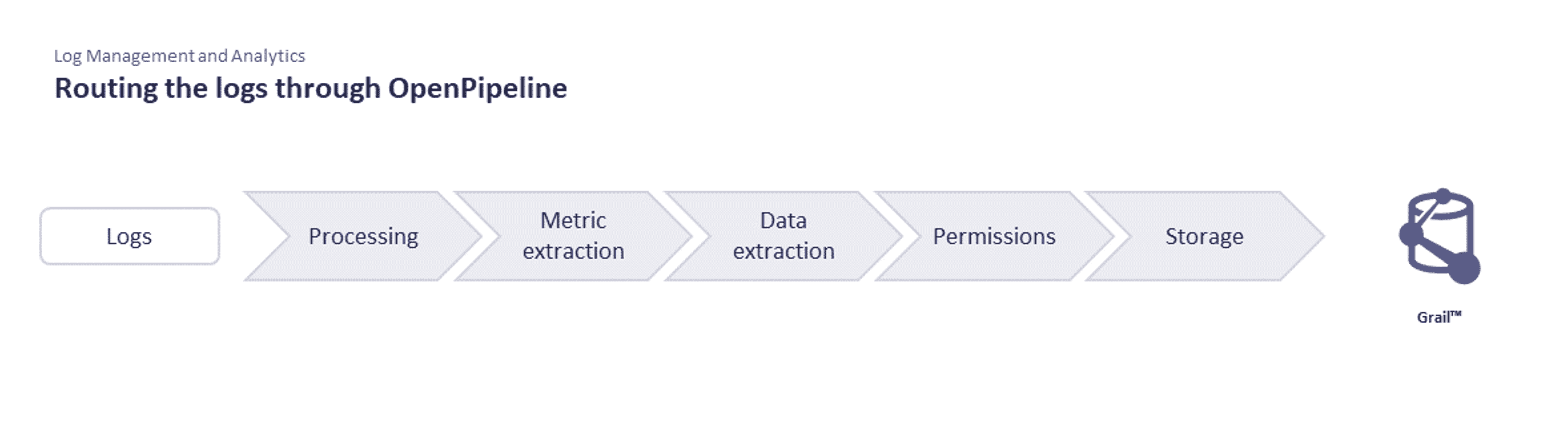

Этапы обработки логов

Этапы обработки логов с помощью OpenPipeline следующие:

| Этап | Описание | Процессы на данном этапе | Выполненные процессы | Поддерживаемые типы данных |

|---|---|---|---|---|

| Обработка | Подготовка данных к анализу и хранению осуществляется путём разбора значений по полям, преобразования схемы и фильтрации записей данных. Поля редактируются, а конфиденциальные данные маскируются.

|

|

Все совпадения | Логи, События — Общие, События — ИИ, События — SDLC, События — безопасности (устаревшие), События безопасности (новые)1 , Бизнес-события, Диапазоны1 2, Метрики3 |

| Извлечение метрических данных | Извлечь метрики из записей, соответствующих запросу.

|

|

Все совпадения | Логи, События — Общие, События — SDLC, События — безопасности (устаревшие), События безопасности (новые)1, Бизнес-события, Системные события, Промежутки1 4, События пользователей, Сеансы пользователей |

| Извлечение данных | Извлеките новую запись из конвейера и повторно вставьте ее как другой тип данных в другой конвейер.

|

|

Все совпадения | Логи, События — Общие, События — SDLC, События — безопасности (устаревшие), События безопасности (новые)1, Бизнес-события, Системные события, Промежутки1 |

| Разрешения | Применить контекст безопасности к записям, соответствующим запросу.

|

|

Только первое совпадение | Логи, События — Общие, События — ИИ, События — SDLC, События — безопасности (устаревшие), События безопасности (новые)1, Бизнес-события, Промежутки1, Метрики3, События пользователей, Сеансы пользователей |

| Хранилище | Распределите записи по наиболее подходящим контейнерам.

|

|

Только первое совпадение | Логи, События — Общие, События — ИИ, События — SDLC, События — безопасности (устаревшие), События безопасности (новые)1, Бизнес-события, Промежутки1 |

1 Данные остаются в исходном, структурированном виде. Это важно для детального анализа и устранения неполадок, поскольку гарантирует отсутствие потери или изменения информации.

2 Обработка диапазонов ограничена процессорами «Удалить поля» и «Удалить записи» в соответствии с ограничениями полей для диапазонов.

3 Определенные поля метрик исключены из сопоставления и обработки. Подробнее см. в разделе Ограничения OpenPipeline.

4 Выборку интервалов можно выполнять с помощью ЕдиногоАгента и OpenTelemetry, однако выборка и агрегация не включаются автоматически в этап извлечения метрик.

Условия конвейера обработки логов и бизнес-событий включены во встроенные конвейеры OpenPipeline. Обработка основана на доступных записях и не учитывает обогащение записей внешними сервисами.

| Если вы определили новые конвейеры и ваши логи направляются на них с помощью определения динамического маршрута, они не будут обрабатываться классическим конвейером. Если логи не направляются ни на один из новых определённых конвейеров, они будут обрабатываться классическим конвейером. |

Включить встроенные правила для OpenPipeline

OpenPipeline предоставляет встроенные правила для распространенных технологий и форматов логов, которые можно включить вручную.

Для обработки логов необходимо включить динамическую маршрутизацию. Подробнее о том, как её включить, см. в разделе Данные маршрутизации.

Чтобы включить их, выполните следующие действия:

- Перейдите в Настройки > Обработка и контекстуализация > OpenPipeline > Логи.

- Выберите вкладку Конвейеры и выберите + Конвейер, чтобы добавить новую запись.

- Введите название.

- Выберите + Процесс на вкладке Обработка и выберите Пакет технологий.

- Выберите технологию, для которой вы хотите включить встроенное правило OpenPipeline.

- Выберите Запустить образец данных, чтобы протестировать его и просмотреть результат.

- Выберите Сохранить.

Добавить пользовательское правило

Чтобы создать новое правило, выполните следующие действия:

- Перейдите в Настройки > Обработка и контекстуализация > OpenPipeline > Логи.

- Выберите вкладку Конвейеры и выберите + Конвейер, чтобы добавить новую запись.

- Введите название.

- Выберите одну из вкладок, представляющих этапы обработки логов: Обработка, Извлечение метрики, Извлечение данных, Разрешение или Хранение .

- Выберите + Процесс и выберите один из доступных процессоров.

- Выберите технологию, для которой вы хотите включить правило OpenPipeline, и укажите определение правила обработки. Определение правила обработки представляет собой инструкцию по обработке логов, описывающую, как Ключ-АСТРОМ должен преобразовывать или изменять данные логов.

- Проверьте определение правила, вручную добавив фрагмент примера лога в текстовое поле Вставить пример лога / JSON. Убедитесь, что он имеет формат JSON. Все текстовые данные логов следует вставлять в

contentполе JSON. - Выберите Запустить образец данных, чтобы протестировать образец JSON, и просмотрите результат.

- Выберите Сохранить.

Вы можете просмотреть или отредактировать любой конвейер, выбрав запись и внеся необходимые изменения.

| Если вы еще не перешли на OpenPipeline, Grail пока не поддерживается в вашем облаке или регионе, или если вы используете Ключ-АСТРОМ версии 1.293 и более ранних, см. Обработка логов. |